De toekomst van Europese AI-wetgeving

Hoe reguleer je AI-wetgeving? Hoe doe je dat op Europese schaal? Redacteur Frank Rensen gaat in gesprek met de experts.

De snelheid waarmee AI (Artificial Intelligence) zich ontwikkelt is geweldig. Zelfrijdende auto’s, onverslaanbare schaakcomputers en bliksemsnelle gezichtsherkenning lijken de normaalste zaak van de wereld. Maar de snelheid waarmee AI vooruitschiet is niet altijd bij te benen door de wet, wat tot onethische en gevaarlijke toepassingen kan leiden. Daarom stapte de Europese Commissie op 21 april als eerste op het wereldtoneel naar voren met een omvangrijk wetsvoorstel om AI te reguleren.

En het is niet voor niets een wereldprimeur, want AI-regulering is op zowel juridisch als op wetenschappelijk gebied een complex onderwerp. Daarom organiseerde SAILS (Society, Artificial Intelligence and Life Sciences), een multidisciplinair programma van de Universiteit Leiden voor academische samenwerking op het gebied van AI, op 25 juni een conferentie over het wetsvoorstel. Tijdens de conferentie zetten deskundigen met ver uiteenlopende achtergronden het voorstel samen uiteen. Hier was LSM te gast en ging na afloop met Anne Meuwese, hoogleraar staats- en bestuursrecht, en Tycho de Graaf, universitair hoofddocent burgerlijk recht, in gesprek. Twee vragen stonden hierin centraal: ‘Hoe reguleer je AI?’ en ‘Hoe goed vervult het voorstel die taak?’

Hoe reguleer je AI?

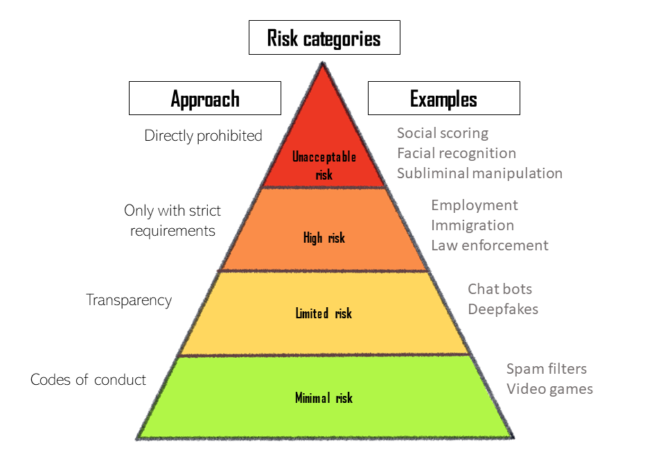

AI is in enorm veel gebieden verwerkt, van onderwijs tot werkgelegenheid. Regulering van AI is daarom een grote uitdaging, omdat de technologische ontwikkeling van AI ook gereguleerd zou worden, met grote gevolgen voor de Europese marktwerking. “Daarom wil de Europese Commissie heel nadrukkelijk ruimte bieden voor innovatie”, stelt Anne Meuwese. De aanpak waar de Europese Commissie met die overweging voor heeft gekozen is risk-based: er wordt onderscheid gemaakt tussen vier verschillende categorieën AI door te kijken naar wat voor risico’s ze mogelijk introduceren. Elk niveau krijgt een eigen definitie, regulering en bijbehorende sancties. De regulering heeft vooral betrekking op AI-systemen die op de Europese markt verschijnen, voor zowel overheden als bedrijven.

Het grondbeginsel is dat het wetsvoorstel Europeanen beschermt tegen AI-praktijken die hen in fysiek of mentaal gevaar kunnen brengen. Een voorbeeld hiervan is een AI-systeem dat bezoekers van een casino sluikreclames voorschotelt om hen aan te sporen hun vergokte geld terug te winnen. Het risico op mentale schade die deze toepassing van AI kan veroorzaken is volgens het voorstel onacceptabel. Een nog extremer voorbeeld is ‘social scoring’, een systeem waarin burgers een score krijgen voor hun gedrag en aan de hand van hun score bepaalde privileges kunnen krijgen of verliezen. De regulering van deze ‘onacceptabele’ AI-systemen is vrij eenvoudig: de toepassingen staan op een zwarte lijst van volledig verboden applicaties van AI.

Echter, veel AI-systemen bevinden zich in een grijs gebied. Dit zijn veelal systemen die betrekking hebben op gevoelige gebieden als werkgelegenheid, onderwijs, immigratie of wetshandhaving. In 2018 werd bijvoorbeeld bevestigd dat een AI-systeem, dat Amazon gebruikte om automatisch CV’s door te nemen, vrouwen sneller afwees dan mannen. Dit kwam doordat de AI was ontwikkeld met ‘trainingsdata’ van alle werknemers van Amazon, voornamelijk mannen. Het gevolg was dat de AI impliciet werd geïnstrueerd om die genderkloof te blijven stimuleren. Om te voorkomen dat iets soortgelijks in de EU gebeurt, stelt dit wetsvoorstel harde eisen aan systemen met een zogenaamd ‘hoog risico’. Denk daarbij aan eisen zoals foutloze trainingsdata, of dat de aanbieder na het uitbrengen van de AI toezicht moet houden en zo nodig het product terugtrekt uit de markt.

Chatbots, deepfakes en videogames

In 2018 demonstreerde Google een nieuw AI-systeem voor de Google Assistant, door het een kappersafspraak te laten maken. De vriendelijke vrouwenstem bootste menselijke trekjes als twijfel en spontaniteit na zonder ooit door de mand te vallen. Dit is al een stuk minder risicovol dan de hiervoor genoemde systemen en wordt beoordeeld als een minimal risk of transparency risk systeem. Een ander voorbeeld is de zogenaamde ‘deepfake’, zoals een introductievideo van MIT waarin Barack Obama vertelt wat de studenten zullen leren in hun ‘Introduction to Deep Learning’. Obama was hierbij natuurlijk niet betrokken, de video was van tevoren gemaakt met AI. Het gebruik van dit soort systemen is in het voorstel alleen toegestaan als aan de mensen die ermee in aanraking komen wordt duidelijk gemaakt dat ze met AI te maken hebben.

De onschuldigste, maar ook meest gebruikte AI-systemen zijn de ‘minimal-risk’ systemen. Hierover zegt het voorstel betrekkelijk weinig: het wordt uiteindelijk aan de aanbieders zelf overgelaten of ze zich door middel van gedragscodes willen houden aan het voorstel. Dit is een coulante aanpak, die alleen voor AI-toepassingen zoals games of spamfilters van toepassing is. Binnen het voorstel wordt zelfs aangemoedigd de gedragscodes op te stellen in samenwerking met de gebruikers van de systemen.

Hoe goed reguleert dit voorstel AI?

Het Europese antwoord op de uitdaging van AI-regulering lijkt dus een grote reikwijdte te hebben. “Om überhaupt na te gaan wanneer dit voorstel wel of niet van toepassing is en zou moeten zijn, is lastig, ook omdat het samenhangt met heel veel andere wetgeving.” aldus Tycho de Graaf. Tijdens de SAILS-conferentie was dit een thema waar doorlopend vraagtekens bij werden gezet: de definitie van AI die het voorstel hanteert. “Er is voor een behoorlijk brede definitie van AI gekozen, één die echt wel breder is dan die veel experts zelf hanteren”, zegt Meuwese. In het voorstel wordt bijvoorbeeld ‘statistische benadering’ ook genoemd als een kenmerk van een AI-systeem. Dit is in veel gevallen te kort door de bocht; een gemiddeld Excel-sheet zou met deze definitie bij wijze van spreken onder AI vallen. Dit is meer dan een nuance, want een te brede definitie kan ertoe leiden dat er te veel of te weinig wordt gereguleerd. De definitiekwestie heeft dus directe gevolgen voor de kracht van het wetsvoorstel in de praktijk.

Verder is de complexiteit van het voorstel op zichzelf een punt van kritiek, zeker als het gaat om de AI-systemen in de ‘hoog risico’ categorie. Vaak moet er een derde partij om de hoek komen kijken om na te gaan dat de AI, of het product waar het deel van uitmaakt, voldoet aan bepaalde kwaliteitseisen. Hierover zegt De Graaf: “Dat is best wel een worsteling, het klinkt eenvoudiger dan het is”, want voor zo’n check zijn namelijk weer heel andere regelingen van toepassing. Deze complexiteit is volgens De Graaf en Meuwese voornamelijk een weerspiegeling van de complexiteit van AI zelf en moeilijk te voorkomen.

Toch geven de deskundigen een aantal redenen voor waarom ze het voorstel verwelkomen. Allereerst is het voorstel een concept voor een zogenaamde ‘verordening’: een wettekst die, in tegenstelling tot een EU-richtlijn, direct werkt en niet door de lidstaten omgezet hoeft te worden in nationale wetgeving. Dit geeft het voorstel direct een zeker aanzien, leidt tot uniformiteit en brengt het onderwerp van AI-regulering van een filosofische naar een juridische kwestie. Ten tweede is de regelgeving zowel voor bedrijven als voor overheden van toepassing. Dat is van belang omdat beide partijen nauw samenwerken bij veel toepassingen van AI. Ten slotte zorgt de risk-based methode van het voorstel ervoor dat er nog ruimte is voor verdere innovatie van AI. Het zal alleen moeten gebeuren op een ‘future-proof’ manier, in harmonie met de wereld van vlees en bloed.

0 Reacties

Geef een reactie